“Transformer完全不能支撑我们下一步,尤其是在Agent时代走向下一步。”12月18日,90后AI大牛、阶跃星辰首席科学家张翔雨公布了自己最新的研究结论,直指当前AI领域核心架构Transformer的技术瓶颈。

Transformer架构是当前人工智能,特别是生成式AI和大语言模型的基石。它是2017 年由谷歌团队在论文《Attention Is All You Need》中提出的深度学习架构,核心创新在于“自注意力机制”,突破了传统循环神经网络(RNN)处理长序列的瓶颈。可以说,没有Transformer,就没有今天的ChatGPT、Gemini等模型。

张祥雨是深度学习领域的知名学者,以在ResNet(残差神经网络)方面的开创性工作而闻名。此前张祥雨等人完成的论文《Deep Residual Learning for Image Recognition》获CVPR最佳论文,引用已超20万次,是计算机视觉与模式识别类被引用最多的论文。

张祥雨首先承认,当前大模型行业看似进入了一个“稳态”时期,各种创新模型架构最终都收敛到以Transformer为核心的变体上。针对长上下文处理的效率瓶颈,业界通过如线性注意力(Linear Attention)、稀疏注意力(Sparse Attention)等技术手段“小修小补”,这并未改变 Transformer 的本质建模能力。

“但是很快我们发现了一个巨大的副作用。”张祥雨说,真正的难点是模型的智商会随着文本变化快速下降。“今天的Transformer,不管号称发布出来说支持到多少Token,基本上到8万个就不可用了。”

这个问题指向了Transformer的一个缺陷,就是它的单向信息流设计。无论输入序列(Context)多长,模型的有效“思考深度”的信息只能从浅层向深层单向传递,缺乏从深层向浅层的反馈与压缩机制,这与人类大脑“无限流”的记忆机制存在本质差异。

“我今天讲过的每一句话,都是历史上我见过的所有信息的函数。”张祥雨用比喻阐明,“这个函数能用层数固定的网络来表示吗?肯定不可以。”他说人类大脑能够对从小到大的海量经历进行动态压缩和选择性回溯,而当前Transformer结构无法实现这种类似“无限流”世界的智能处理需求,这制约了AI向具备高度自主性、能长期持续学习的通用Agent演进。

事实上,当前已经开始有研究者讨论Transformer是否存在根本局限性。就在今年10月,Transformer 架构的共同创造者Llion Jones在TED AI大会上说自己已经受够了 Transformer,并开始寻找下一次重大突破。他直言尽管现在AI领域投入了前所未有的资金与人才,但研究者却变得越来越狭窄,他们更倾向于利用现有架构而非探索新路径,“错失下一个重大突破的风险正在加剧。”

挑战已经出现。Mamba、TTT(Test-Time Training)等架构正吸引越来越多目光。英伟达、Meta、腾讯等巨头已在探索将Mamba与Transformer融合;中国科学院自动化所与沐曦合作研发的类脑脉冲大模型“瞬悉1.0”,则展示了构建非Transformer架构生态的可行性。

张祥雨透露,阶跃星辰团队已经在探索新的架构方向,一些小规模实验已取得积极结论。他认为,未来的架构是基于非线性递归网络(non-Linear RN)的全新架构。但他也坦言,这种架构革新将给系统效率和可并行度带来巨大挑战,需要协同设计才能落地。

举报 第一财经广告合作,请点击这里此内容为第一财经原创,著作权归第一财经所有。未经第一财经书面授权,不得以任何方式加以使用,包括转载、摘编、复制或建立镜像。第一财经保留追究侵权者法律责任的权利。如需获得授权请联系第一财经版权部:banquan@yicai.com 文章作者

刘佳

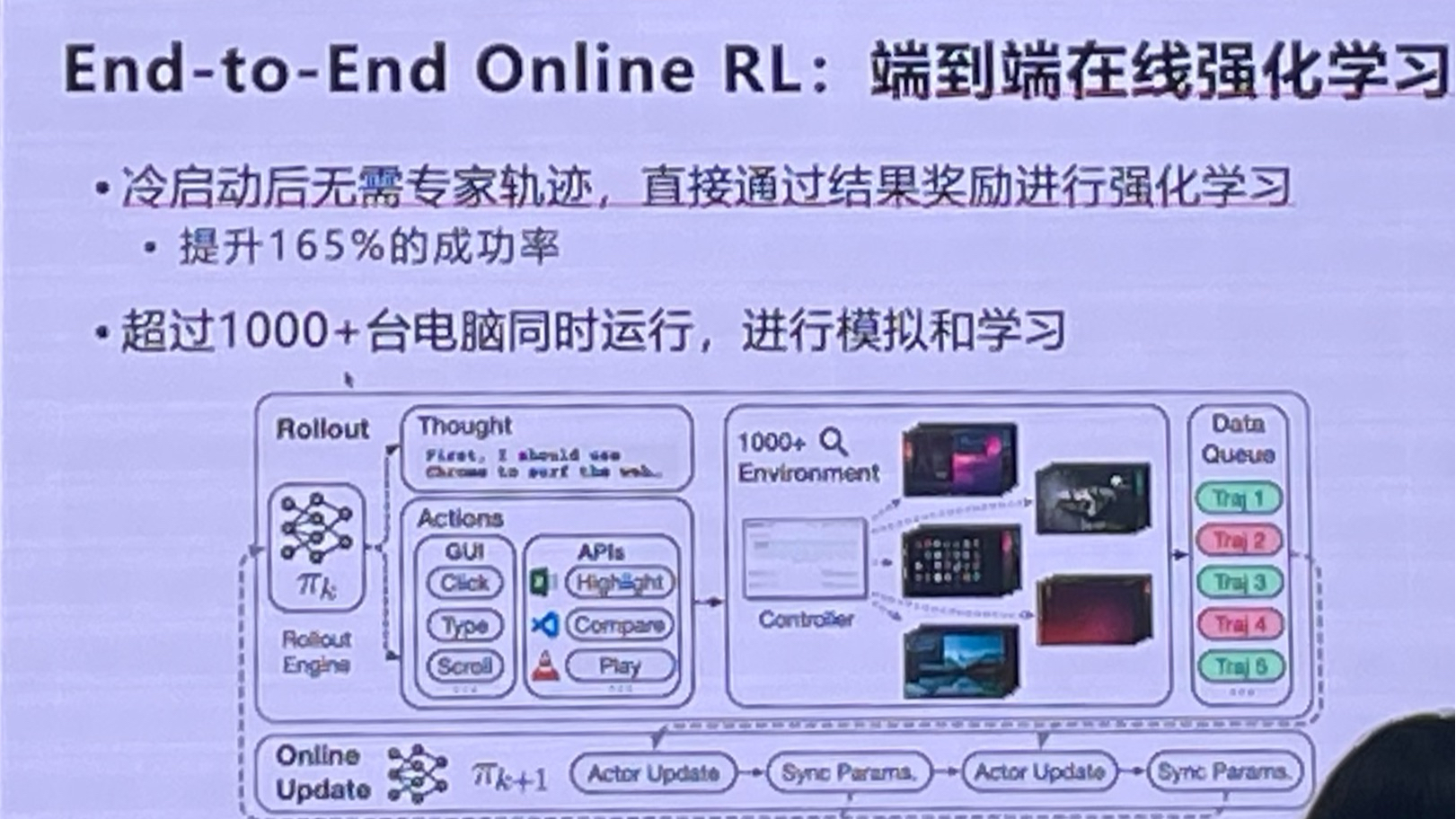

相关阅读 拐点来临!亚马逊云科技开启Agent时代,数十亿Agents重构产业生产范式 65 12-10 19:08

拐点来临!亚马逊云科技开启Agent时代,数十亿Agents重构产业生产范式 65 12-10 19:08  从云栖大会看下半年AI三大趋势:软硬件结合、Agent、具身智能

从云栖大会看下半年AI三大趋势:软硬件结合、Agent、具身智能AI产品要提高收入,Agent要进入企业,具身智能要接地气。

76 10-09 15:56 向大厂叫板?零一万物瞄准企业Agent私有化新战场

向大厂叫板?零一万物瞄准企业Agent私有化新战场除了工程落地之外,架构范式也是Agent在B端落地的难题。

177 09-26 17:03 鸿蒙砸下十亿,打响AI Agent入口战

鸿蒙砸下十亿,打响AI Agent入口战华为宣布启动“天工计划”。

5 298 09-20 20:48 单任务成本约0.2美元,智谱要用云端Agent抢市场

单任务成本约0.2美元,智谱要用云端Agent抢市场智谱AutoGLM单任务成本约0.2美元。

97 08-20 20:43 一财最热 点击关闭万隆优配提示:文章来自网络,不代表本站观点。